春节前打响“百模大战”:AI生图为何突然“开窍”了?

文丨AI研究员 卢菁博士

编辑 丨李海伦

2月10日,阿里巴巴Qwen-Image-2.0与字节跳动Seedream 5.0预览版同日登场,掀起了春节档前夕的“AI生图大战”。

这两款模型的发布引起了广泛关注,不只是因为发布时间“撞车”,更因为它们共同指向了AI生图的变化:目前,AI生图在可控生成、文字还原、多场景适配等关键能力上,和以前相比有了明显进步。

回溯AI生图的发展轨迹,从“破圈”到“成熟”,这个赛道只用了不到四年时间。

2022年,一张用Midjourney生成的《太空歌剧院》拿下美国科罗拉多州博览会艺术比赛冠军,瞬间引爆全网,成为“AI生图”的代名词。不过,那时候的Midjourney,离走向大众始终隔着好几道门槛:付费订阅、Discord操作、复杂的指令等等,使它看起来更像是一款专业的创作工具。

当时,整个行业还处在早期探索阶段,大家更多在尝试“AI能不能画出好看的图”,而不是“AI能不能解决实际问题”。

转折点出现在2025年初,谷歌Nano Banana凭轻量化的优势杀出重围,将AI生图推广到了更多的大众面前。

这一年,各家厂商都在加速入局。比如腾讯混元大模型,在LMArena 2025年10月发布的文生图榜单中,混元图像 3.0(HunyuanImage 3.0)在全球 26 个主流模型中位居第一,国内厂商的技术实力开始显现。

到2026年初,图像大模型已经变成了多家大模型厂商的角力场:Qwen-Image-2.0、Seedream 5.0,在春节假期前夕,吹响了激战的号角。

短短几年,这个行业已从单款模型出圈演变为巨头们的亮剑竞赛,AI生图究竟经历了怎样的蜕变?曾经的“AI生图天花板”Midjourney,为何在2026年逐渐缺位?

本篇主要以Qwen-Image-2.0、Seedream 5.0和Nano Banana为例——前两者代表了国内头部厂商在图像生成领域的最新进展,Nano Banana则是2025年率先打开大众市场的轻量化代表,我们聚焦这三款模型的技术路线不同点,用直接通俗的表述,讲清楚这些关键问题。

01

AI生图为什么突然“开窍”了

过去一年,AI生图完成了从“能画图”到“能干活”的质变:不再拼参数和速度,而是拼可控性、叙事能力和落地场景。

先看两个关键时间节点的分水岭:

2025年,Nano Banana引爆了“轻量普惠”时代。在此之前,AI生图是“高端玩家专属”,它需要复杂操作,还经常生成一堆没法用的图。直到谷歌Nano Banana出圈,才算打破这个壁垒:能做到图文原生融合,不用复杂指令也能快速出图。

这次字节和阿里同日发布的新模型,也是技术突破的集中体现:Qwen-Image-2.0的创新点在于首次将图像生成与编辑功能统一到单一模型架构中,使出图效率有明显提升。字节跳动的Seedream 5.0则强调智能水平的提升,增强了对提示词的理解能力,支持检索生图、多步逻辑推理和联网知识整合。

这种技术跃迁的背后,是4大核心能力的突破:

○ 多模态原生融合:文字生成不再是弱点。过去扩散模型最大的槽点就是“图里的字乱码”,现在通过多模态原生融合,模型能精准理解需求并生成准确文本。生成一页PPT,不只是图表准确,上面的标题、数据标注也能一次到位。

○ 物理世界对齐:告别“反物理”画面。生成的画面开始符合真实世界的物理规律:光影方向统一、材质质感真实、空间关系合理。金属该有的反光、布料该有的褶皱都精准呈现,不会再出现“人在雨中跑,影子却在晴天”这种离谱bug。

○ 可控生成:从“随机抽卡”到“指哪打哪”,终于能精准控制细节了:局部修改不影响整体、同一风格可以贯穿全套、多轮编辑不会“变脸”。做一套电商图,能保持统一画风;改个产品颜色,不用整张图重新生成。

○ 动态叙事:能够理解复杂需求,主动推理。不再是“你说什么我画什么”,而是AI能理解背后的业务逻辑。输入“生成一套产品营销图”,模型会自动推理出需要主KV、详情页、banner等多种尺寸和用途,一键输出完整交付物。

02

技术路线不同,擅长的活儿也不同

很多人可能有这样的疑问:不少模型看起来都能文生图、做编辑,实际用起来到底有什么区别?

其实核心差距在“技术路线”上,如果说共性是“都会做饭”,那差异就是“有人擅长中餐、有人擅长西餐、有人擅长高端私宴”,擅长的场景完全不同。

先看共性:这些模型的“底层共识”。不管各家侧重点怎么变,核心逻辑是一致的:都在主打端到端多模态图像生成。新手选型前,可以先了解热门好用的大模型,具备的共同点:

首先是功能上一站式搞定。文生图、图生图、图像编辑、局部修改、风格切换……一个工具全覆盖,不用来回切换平台。过去可能需要三四个软件配合完成的流程,现在一个模型就能闭环。

其次是AI能真正理解创作意图,用户不需要把需求描述拆解。比如你对AI说“给我做一套电商主图”,它懂的是整套视觉方案,而不是机械地只给你一张。不过,这里建议用户说的提示词内容尽量清楚和精准,效果会更好。

还有性能上,生成效率高。深度优化扩散模型算法,生成速度大幅提升的同时质量不打折。以前可能要等几分钟才能出一张图,现在几秒钟就能看到结果。

此外还能适配于商用场景,支持细节微调、多图风格统一,能真正满足电商、设计、营销等商业场景的交付标准。

大模型各自的技术路线不同,实际表现出来的特点也不一样。下面从几个典型场景切入,看看不同模型在这些场景下的表现:

先来看中文创作场景。

以Qwen-Image-2.0为例,技术路线上,Qwen采用MMDiT多模态扩散架构,把生图和编辑能力整合到一个模型里。

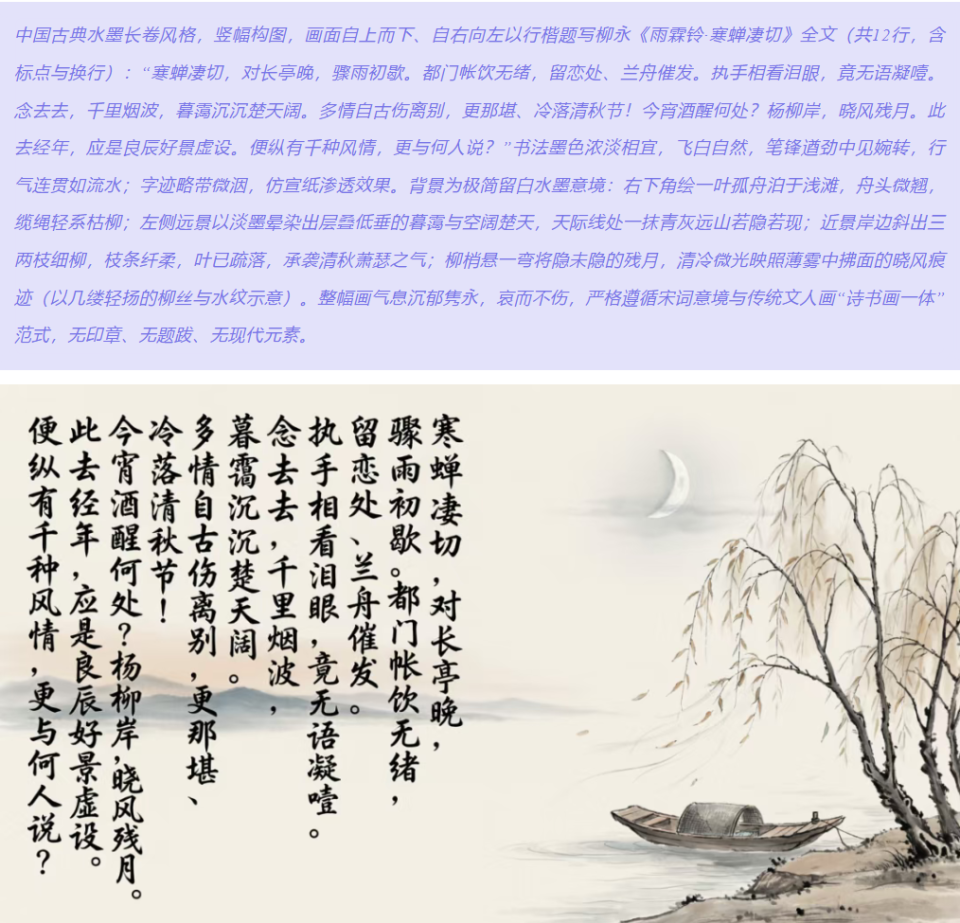

具体来说,它能解析比较长的中文指令(支持最多1000个字符),对中文文字的生成也相对准确。比如生成带有古诗词的图片,像《雨霖铃·寒蝉凄切》这类文本,在字形、排版上能保持较好的还原度。对于需要在图片中准确呈现中文文字的场景,比如海报、广告图等,这类能力会比较实用。

不过这类能力的局限在于,在一些需要理解最新信息或复杂知识的场景下,可能会受限于训练数据的时效性。

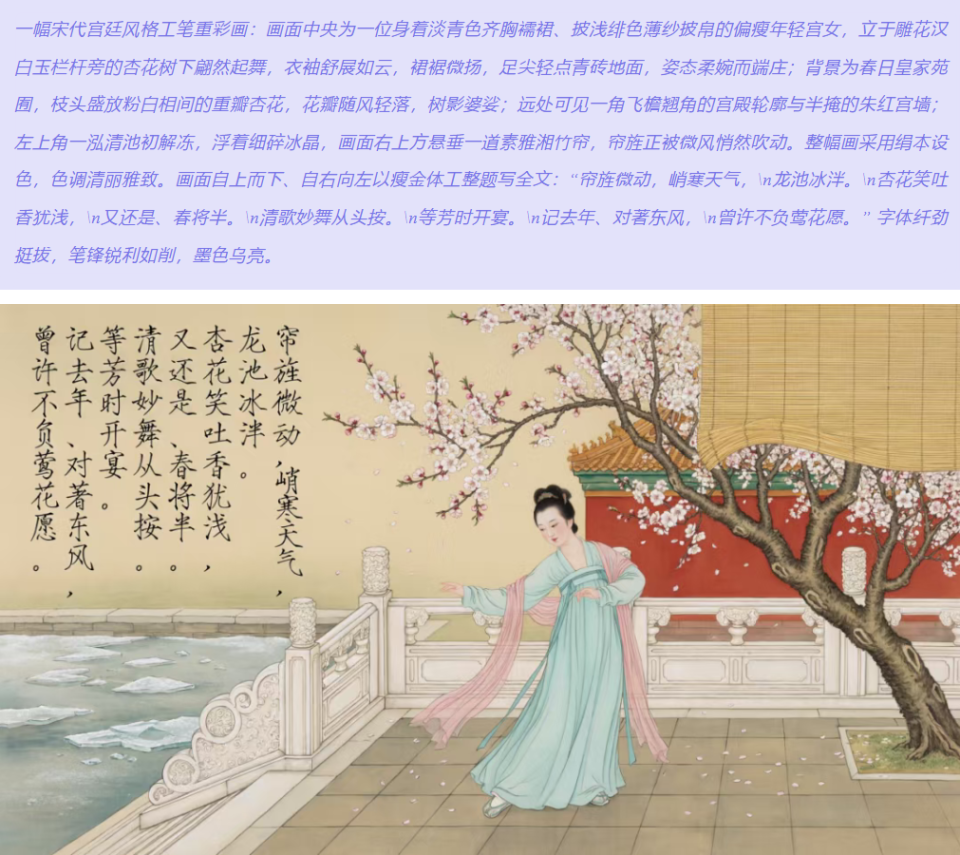

Qwen-Image-2.0也支持多种字体,比如说,可以用宋徽宗赵佶的瘦金体来书写他创作的宋词《探春令·帘旌微动》:

另一个典型场景,是对内容时效性有要求的创作需求。

以Seedream 5.0为例,它采用混合多模态架构,加入了RAG知识库和联网检索能力。简单说,就是模型在生成图片时,可以先去查资料、理解上下文,再进行创作。

这带来的实际变化是:如果你要生成一些涉及新事物的图片,比如2026年新发布的某款手机、最近的热点事件场景,它可以通过检索获取真实信息后再生成,而不是完全依赖训练数据“瞎猜”。这对需要时效性内容的场景会有帮助。

不过,这类技术路线的局限是联网检索的结果不一定百分之百准确,毕竟,网上的内容本身就良莠不齐,生成内容最好有人工核实和验证。

还有一类场景是创意内容生成。这类需求的特点是指令往往比较抽象,需要模型真正理解创作意图,而不是机械执行字面意思。

比如我输入一个“李白漫游太空”的创作指令,大模型能理解这是一个超现实风格的创意需求,而不是字面意思,生成的画面会在保持古典诗人形象的同时,融入太空场景。

大模型还可以对细节编辑把控:能理解复杂矛盾需求。比如同一张图可以在保持其他元素不变的情况下,单独调整人物的表情,生成不同情绪状态的版本。

还有对画面真实感和角色一致性要求比较高的场景。以Nano Banana为例,它采用Flow-Matching架构,在光影、材质、物体空间关系等物理细节的还原上表现相对自然。角色一致性也比较稳定,同一人物在不同场景、不同服装下基本能保持特征不变,适合故事绘本、IP设计这类需要多张图风格统一的需求。

Nano Banana作为轻量化模型,硬件门槛较低,普通笔记本也能运行。不过它的局限也比较明显:中文理解能力有限,也不支持联网检索,在需要时效性内容的场景下会受限。

03

AI生图的竞争逻辑变了吗?

回顾Midjourney,画风出色、创意能力强,是很多创作者的常用工具。但到了2026年,随着更多大模型厂商的出现,Midjourney在市场上的声量明显下降,不是它的能力退步了,而是行业需求变了。

Midjourney走的是和当前主流模型不同的技术路线:在文本理解深度与可控生成方面的能力侧重有所不同。它的技术路线有其优势:在创意发散上表现突出。它擅长将模糊的想法转化为视觉呈现,风格多样性强,比如“赛博朋克+中国山水”这类跨风格组合,Midjourney能给出多种方案,艺术完成度较高,适合“从0到1”的创意探索阶段。

不过,其中的局限表现也很明显:精细化控制能力不足。同一角色多次生成可能出现形象不一致的情况,局部修改容易影响整体,生成速度相对较慢,这些特点使得它难以满足需要批量生产、风格统一的商用场景,比如电商图、短剧分镜等。

到2026年,行业的核心需求已经从创意探索转向高效生产,可控性、场景适配等能力成为更重要的评价指标。当前行业比拼的焦点,主要集中在3个方面:

第一,可控性:能否精准响应需求。这是行业从实验性工具走向生产工具的关键转折。早期的AI生图,核心指标是生成质量;现在的核心指标变成了“需求匹配度”,能否理解复杂指令、能否控制具体细节、能否保证同一主体在多次生成中保持一致。

举个例子,过去生成电商图可能需要生成50张才能筛选出5张可用的,现在输入明确指令后,第一批生成结果的可用率就大幅提升。从这个角度看,采用知识增强架构的Seedream、针对中文长指令优化的Qwen,在商用场景下的可用率相对更高。

第二,场景适配性。当前行业呈现明显的场景分化趋势。比如字节将Seedream集成到剪映,切入短视频、短剧制作流程;阿里的Qwen瞄准电商、办公场景,计划与阿里系生态打通;Nano Banana则主要面向专业摄影、影视领域。深度绑定具体场景的模型,往往能建立更强的竞争壁垒。

第三,生态整合力。技术轻量化只是第一步,真正让更多人用起来才是关键。比如Seedream目前提供限时免费使用,支持2K、4K输出;Qwen上线了千问APP,操作相对简单。

短期内,不同技术路线会在各自擅长的场景占据位置。长期来看,单纯拼生成质量已经不够,能够整合知识理解、场景适配和生态支持的技术路线,可能更符合行业发展方向。至于哪条路线走得更远,还得看实际应用效果和市场反馈。

04

AI生图的下一步

从2025年的轻量化普及,到2026年的可控落地,AI生图的进化速度确实挺快。结合当前的技术趋势,未来图像大模型可能会朝着几个方向发展:

首先,毋庸置疑的一点是AI生图的普及程度会更高。轻量化技术会让更多设备都能流畅运行,不管是普通电脑还是手机。免费试用、低成本部署的选项也会增加,让中小企业和个人创作者都能用上原本只有大公司才能负担的工具。

其次,未来的模型会更“懂”用户需求。AI理解的不只是执行指令,还能理解背后的意图。比如用户说“生成一款夏季连衣裙海报”,模型可能会自动判断夏季的流行色系、适合的使用场景(电商详情页还是社交媒体),甚至根据你以往的创作风格,生成更贴合你习惯的方案。这样就不用每次都详细描述需求,能省不少事。

第三,AI生图在场景适配上加深——技术和具体场景的结合会越来越紧密。比如在电商领域,商家可以实现一键生成整套产品图,并自动适配不同平台的规格要求;在短剧制作领域,输入剧本就能生成分镜图,甚至直接转成视频,大幅降低制作成本;在设计领域,可能会支持像PS那样的图层分离编辑,让专业流程更顺畅。

同时,使用门槛也会继续降低。以后可能不需要用户写复杂的提示词,只要上传一张参考图加一句简单描述,就能得到想要的结果。

未来,大模型的实际应用也会不断推动技术持续改进。比如短剧、电商这些场景产生的具体需求,会促使模型在多图关联、角色一致性等方面不断优化。应用场景丰富的地区,在技术迭代上可能会有自己的优势。

总之,对于创作者和企业来说,选对适配自己场景的模型,就能抢占效率红利;而对于行业来说,这种“可控、落地、普惠”的进化,才是AI生图真正的价值所在。*注:童同对本文亦有贡献,参与创作和修订。